Contexte

Les outils reposant sur l’intelligence artificielle (IA) à disposition des organisations se développent de manière exponentielle et peuvent modifier significativement le rapport au travail dans de nombreux domaines d’activités. Les innombrables opportunités offertes par l’IA ne sont plus à démontrer, au même titre que la nécessité pour les organisations d’encadrer son usage.

Souvent négligé, un aspect crucial des systèmes d’IA concerne les biais inhérents. Ces derniers se manifestent de différentes manières, affectant tantôt la prise de décision, l’équité ou l’efficacité.

Il est important pour les utilisateurs et pour les dirigeants d’être conscients de ces biais afin de les gérer efficacement et d’en tenir compte dans les résultats produits par des systèmes d’IA. Ce d’autant plus que le développement de systèmes d’IA exempt de tout biais au niveau de leurs données d’entrainement et de leur modèle semble illusoire.

Comprendre les biais des systèmes d’IA

Pour faire des prédictions ou prendre des décisions, les systèmes d’IA ont recours à des algorithmes souvent basés sur des corrélations statistiques apprises à partir de données d’entrainement. Ces données doivent être pertinentes et les plus représentatives possibles pour éviter de biaiser les résultats.

La partialité non désirée dans les systèmes d’IA peut influencer les résultats de manière variée, affectant certains groupes plus que d’autres.

Pour éviter d’affecter certains groupes de personnes, il serait souhaitable que les systèmes d’IA prédisent efficacement sur la réponse à une requête présente un risque acceptable. À titre illustratif, la prise en compte de l’âge dans le cadre d’un traitement médical est importante, alors qu’elle représente un risque avéré dans le cadre du traitement d’un dossier de candidature.

En cela l'identification et la gestion des biais nécessitent une analyse minutieuse des critères et des effets potentiels de ces biais. Ces effets peuvent être positifs, neutres ou négatifs, selon le contexte et les objectifs des systèmes d'IA. Voici des exemples d’effets de biais dans le cadre d’un système d’IA visant à assister une organisation dans le traitement de dossiers de candidature :

- Positif : Le développeur pourrait introduire un biais volontaire en faveur d’un genre plutôt qu’un autre. Cela afin de compenser le biais sociétal hérité des données d’entrainement dans le cas où lesdites données reflètent une sous-représentation d’un genre dans un métier spécifique.

- Neutre : L’effet pourrait être neutre si l'algorithme a tendance à mal évaluer certains critères qui n'affectent pas significativement la décision finale, comme la mise en page d'un CV. Ces biais n'ont pas d'impact majeur sur l'équité ou les résultats de l'embauche.

- Négatif : Le système d’IA pourrait favoriser les candidats qui ont des expériences professionnelles sans interruption. Ce biais négatif, même s'il est non intentionnel, pourrait conduire à écarter injustement des candidats qualifiés qui auraient interrompu leur carrière pour élever des enfants ou pour effectuer un voyage humanitaire.

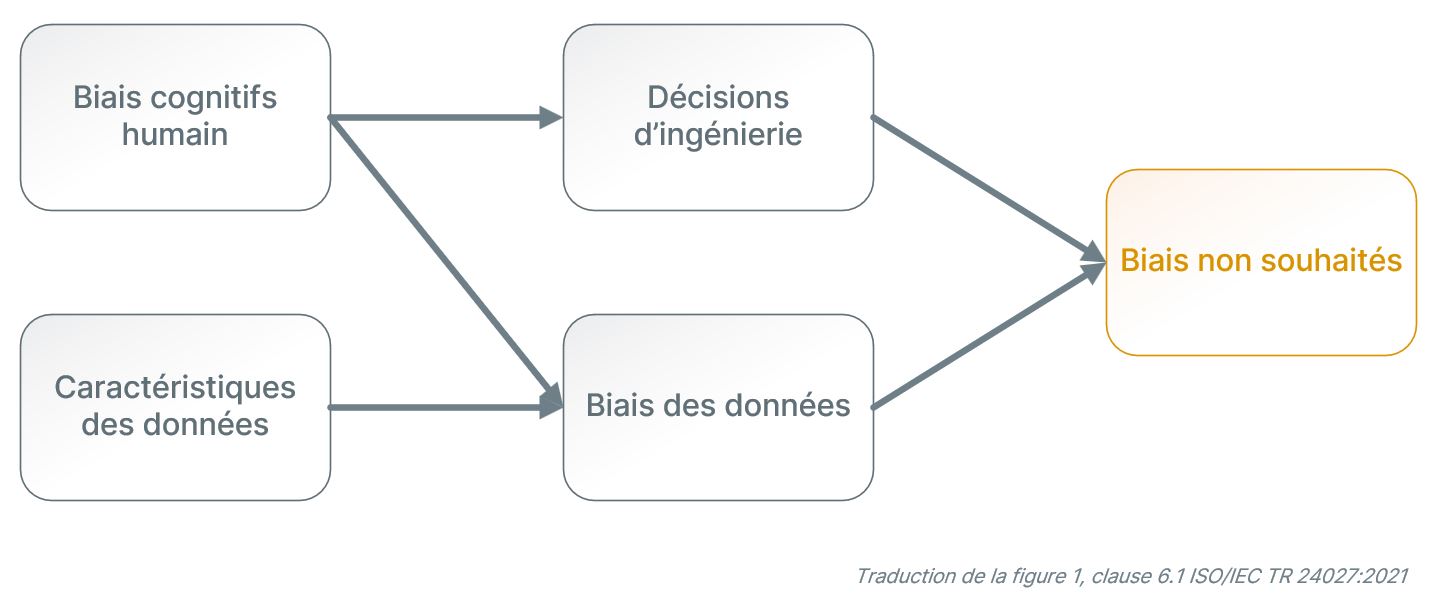

Les systèmes d’IA peuvent présenter plusieurs biais, qui proviennent de différentes sources, à l’instar des humains (biais cognitifs humains), des préjugés inconscients des développeurs (biais d’ingénierie) ou des données d'entrainement (biais des données). Un système d’IA peut présenter simultanément plusieurs sources de biais.

Biais cognitifs humains

Ces biais, conscients ou inconscients, proviennent des perceptions et des expériences personnelles des développeurs ou des utilisateurs des systèmes d’IA. Le raisonnement humain amène parfois les personnes à prendre des décisions sans forcément savoir quels sont les éléments qui y ont conduit.

Les biais cognitifs humains peuvent être le résultat de stéréotypes sociaux, de préférences personnelles, ou de la tendance à favoriser les informations qui confirment les croyances préexistantes. Par exemple, nous parlons de biais d’expérimentateur lorsque la personne qui entraine le modèle continue l’entrainement jusqu’à ce qu’une hypothèse préexistante soit confirmée.

Décisions d'ingénierie

Ces biais surviennent en raison de choix spécifiques dans la conception des systèmes d'IA. Ils peuvent être liés à la sélection des modèles d'apprentissage automatique (Machine Learning), à la manière dont les données sont prétraitées, ou aux critères utilisés pour évaluer la performance de l’outil. Par exemple, choisir un modèle statistique qui ne capte pas correctement la variabilité au sein des données peut conduire à des prédictions inexactes ou biaisées.

Biais des données

Ces biais proviennent de la nature des données utilisées pour l'entrainement des systèmes d'IA. Si les données sont déséquilibrées, incomplètes, ou contiennent des erreurs systématiques, le système d’IA apprendra et perpétuera ces biais.

Un exemple typique est un système de reconnaissance faciale formé sur des données majoritairement constituées d'images de personnes appartenant à un seul groupe ethnique, résultant en une moins bonne reconnaissance des visages d'autres groupes ethniques. Le processus d’étiquetage des données lui-même peut introduire des biais cognitifs dans les données. Par exemple, l’étiquetage de photos de mariage en se basant sur la présence d’une robe blanche introduira un biais sociétal dans les données. Par ailleurs, l’utilisation de données collectées dans un certain contexte qui serviraient à entrainer un modèle dans un tout autre contexte induirait certainement des biais de données.

Impact des biais sur les organisations

Les biais dans les systèmes d’IA peuvent avoir des répercussions significatives sur les organisations qui les utilisent, affectant leur efficacité, leur éthique et potentiellement leur conformité légale. Par exemple, un système de crédit basé sur l'IA pourrait, en raison de biais, rejeter injustement des demandes de prêt de certains groupes sociaux. Cela pourrait non seulement entrainer des accusations de discrimination, mais aussi porter atteinte à la réputation de l'entreprise. Il est donc important pour les organisations d'identifier et de gérer ces biais pour garantir des décisions justes et éthiques, ainsi que pour maintenir la confiance de leurs clients et partenaires.

D'autre part, la gestion inadéquate des biais peut entraîner des conséquences financières directes. Les erreurs de jugement ou de décision induites par des biais peuvent conduire à des pertes économiques, que ce soit par des erreurs de prédiction de marché, des investissements mal orientés, ou des stratégies marketing inefficaces. De plus, et en fonction de l’évolution des législations, les organisations pourraient faire face à des litiges coûteux si elles sont jugées responsables de pratiques discriminatoires dues à l'utilisation de systèmes d’IA biaisés. Par conséquent, il est essentiel pour les organisations non seulement d'investir dans des systèmes d’IA démontrant leurs engagements éthiques, mais aussi de mettre en place des mécanismes de contrôle rigoureux et transparent pour surveiller et corriger continuellement les biais potentiels.

Identifier et gérer des biais

L'identification des biais dans les systèmes d'IA nécessite une approche proactive et multidisciplinaire. Initialement, il est intéressant de s’assurer que le fournisseur de la solution a procédé à un audit approfondi des données utilisées pour entraîner ses algorithmes. Il est également important de mettre en place des mécanismes de feedback continu pour que les utilisateurs puissent signaler des anomalies ou des cas de résultats biaisés. Parallèlement, des processus d'évaluation régulière, tels que des tests de robustesse et de justesse, devraient être intégrés par les fournisseurs dans le cycle de vie du développement des systèmes d'IA.

Les grandes organisations pourraient également envisager de mettre en place en leur sein un comité éthique, composé d'experts en données, d'éthiciens, de juristes et de représentants des utilisateurs, afin de superviser et orienter les décisions relatives à l'implémentation des systèmes d'IA.

Prendre des mesures et encadrer l’utilisation

La mise en place d'un cadre réglementaire et de gouvernance interne est fondamentale pour encadrer l'utilisation des systèmes d'IA dans les organisations.

Nous recommandons que ce cadre intègre des lignes directrices claires sur l'utilisation de l'IA, ainsi que des procédures de conformité et de reddition de comptes. Il est important que ce cadre soit transparent et accessible à tous les collaborateurs, et qu'il soit régulièrement mis à jour pour refléter les évolutions technologiques et réglementaires.

Les organisations peuvent également envisager de réaliser des audits externes périodiques pour évaluer l'efficacité de leurs politiques et pratiques en matière de biais en IA. Finalement, la sensibilisation et la formation continue des collaborateurs sur les risques liés aux biais en IA sont essentielles pour assurer une utilisation responsable et conforme de ces technologies. En promouvant cela, les organisations peuvent non seulement améliorer la fiabilité et la justesse de leurs outils d'IA, mais aussi renforcer la confiance de leurs clients, de leurs collaborateurs et de leurs partenaires.

Cet article repose notamment sur le rapport technique ISO/IEC TR 24027:2021 qui traite des biais dans les systèmes d’IA et dans la prise de décision assistée par l’IA.